- Untersuchung zu Unfällen mit Teslas

- Viele verblüffende Vorfälle

- Zu wenige Warnungen und ein irreführender Name

Die amerikanische Straßensicherheitsbehörde stellt dem Autopiloten von kein gutes Zeugnis aus. Es gäbe gravierende Sicherheitsmängel. Daten von beinahe 1000 Unfällen zeichnen ein klares Bild. , 26.04.2024 18:13 Uhr

Untersuchung zu Unfällen mit Teslas

Erst vor ein paar Wochen hatte über seinen eigenen Kurznachrichtendienst X (ehemals Twitter) angekündigt, Tesla wolle völlig Robo-Taxis auf den Markt bringen. Die Fahrzeuge sollen am 8. August dieses Jahres von Musk höchstpersönlich vorgestellt werden.Doch jetzt bescheinigt eine der Software, die in den bisherigen Tesla-Modellen verbaut ist, grobe Sicherheitsmängel. Dem Bericht zufolge wiege der Autobauer seine Kunden beim Verwenden der automatischen Fahrsysteme in falscher Sicherheit. Es sei daher schon zu unzähligen Unfällen gekommen.

Viele verblüffende Vorfälle

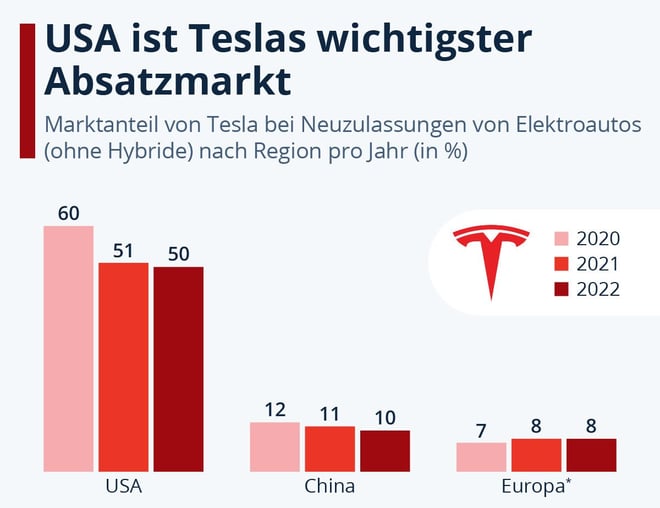

Die Studie schaute sich dabei die Daten zu 956 Unfällen an, die sich zwischen Januar 2018 und August 2023 ereignet hatten. Dabei waren insgesamt 29 Menschen ums Leben gekommen. Bei 211 dieser Unfälle war ein Tesla frontal in andere Fahrzeuge oder stationäre Hindernisse gefahren. Infografik Elektromobilität: Die USA sind Teslas wichtigster Absatzmarkt

In weit über einem Viertel dieser Fälle sei das Hindernis fünf oder mehr Sekunden lang vor dem Aufprall klar und deutlich sichtbar gewesen. In 19 Fällen sogar über zehn Sekunden lang. Die menschlichen Fahrer hatten aber nicht reagiert. Das verrieten die Log-Daten der entsprechenden Fahrzeuge, die der NHTSA von Tesla bereitgestellt wurden.

In weit über einem Viertel dieser Fälle sei das Hindernis fünf oder mehr Sekunden lang vor dem Aufprall klar und deutlich sichtbar gewesen. In 19 Fällen sogar über zehn Sekunden lang. Die menschlichen Fahrer hatten aber nicht reagiert. Das verrieten die Log-Daten der entsprechenden Fahrzeuge, die der NHTSA von Tesla bereitgestellt wurden.

Zu wenige Warnungen und ein irreführender Name

Die Behörde nimmt Tesla in die Verantwortung und sieht gravierende Probleme mit dem Autopilot-System. Denn bei einem Vergleich der Level 2 (L2) Automationsfunktion des Unternehmens mit vergleichbaren Produkten der Konkurrenz, fällt Tesla vor allem durch eine extrem schwache Einbindung des Fahrers und mit äußerst liberalen Betriebsfunktionen auf.Demnach stellt das L2-System nicht ausreichend die Aufmerksamkeit der Fahrer sicher, was dazu führt, dass die schnell abschalten. So gibt es kaum Warnhinweise und Sicherheitsfunktionen können mit einfachsten Mitteln ausgehebelt werden. Auch der irreführende Name “Autopilot” suggeriere, das System wäre völlig von alleine in der Lage, das Fahrzeug sicher zu bewegen, so die NHTSA. Das verschärfe das Aufmerksamkeitsproblem noch einmal.Tesla hatte schon Ende des vergangenen Jahres Fahrzeuge zurückgerufen und neue Warnmeldungen eingebaut. Ob nun ein weiteres Update kommt, ließ der Autobauer bislang nicht wissen.

Zusammenfassung

- Untersuchung zeigt Sicherheitsmängel in Tesla-Software

- NHTSA-Bericht: Falsche Sicherheit durch Autopilot-System

- Untersuchung analysierte 956 Unfälle mit 29 Todesfällen

- Hindernisse waren oft mehrere Sekunden sichtbar

- NHTSA kritisiert Teslas schwache Fahrereinbindung

- Irreführender Name “Autopilot” suggeriert Vollautonomie